Kapitel 11 Sådan måler ICILS kompetencer og kontekster

I dette kapitel beskrives de instrumenter der blev udviklet i forbindelse med ICILS 2013 og 2018 til at måle elevernes computer- og informationskompetence og deres kompetence til datalogisk tænkning samt til at måle træk ved konteksten for udviklingen af disse kompetencer. Først præsenteres målgruppe og samplingsdesign for undersøgelsen. Herefter bliver de forskellige undersøgelsesinstrumenter der blev anvendt i ICILS, gennemgået. Først gennemgår vi kort spørgeskemaerne som giver indblik i konteksterne, og dernæst beskriver vi mere grundigt testinstrumenterne – først for computer- og informationskompetence og dernæst for datalogisk tænkning. Under hver del præsenteres først testmodulerne, og dernæst beskrives hvordan kompetenceområderne for hver af de to overordnede kompetencer er blevet operationaliseret, og hvordan skalaen for dem blev udledt fra testinstrumentet. For at vise karakteren af de opgaver der indgik i målingen, præsenteres der herefter eksempelopgaver fra testmodulerne samt tilhørende vurderingskriterier i forhold til kompetenceniveauerne som er beskrevet i henholdsvis kapitel 3 og 4. Endelig beskrives det hvorledes de kvalitative vurderinger af opgavebesvarelserne foregik.

11.1 Undersøgelsens design

Som nævnt i kapitel 2, deltog i alt 12 lande og to benchmarkdeltagere i ICILS 2018: Danmark, Chile, Finland, Frankrig, Tyskland, Italien, Kasakhstan, Sydkorea, Luxembourg, Portugal, USA, Uruguay, Moskva (Rusland) og den tyske delstat Nordrhein-Westfalen. Ikke alle lande deltog i undersøgelsen af datalogisk tænkning der i 2018 blev udviklet som en tilvalgsmulighed. Denne del valgte de otte lande Danmark, Finland, Frankrig, Tyskland, Sydkorea, Luxembourg, Portugal og USA at deltage i.

I 2013 deltog 18 lande, men kun fire af disse valgte at deltage i 2018: Danmark, Tyskland, Chile og Sydkorea. Det lille antal gengangere betyder at det har været mindre relevant at sammenligne hvilken udvikling der er sket i de danske resultater og kontekst med tilsvarende udvikling i andre lande.

11.1.1 Populationsdefinitioner

Elevpopulationen i ICILS består som udgangspunkt af elever der gik i 8. klasse på både private skoler og folkeskoler i foråret 2018. ICILS definerer elevpopulationen ud fra at eleverne skal have modtaget otte års formel skoleundervisning68, og at elevernes gennemsnitlige alder på 8. klassetrin mindst er 13,5 år. Hvis elevernes aldersgennemsnit i en 8.-klasse er under 13,5 år, foretages undersøgelsen i 9. klasse i stedet for. Alle skoletyper indgår i undersøgelsen.

Populationen for lærerspørgeskemaet udgøres af lærere der underviste på klassetrinnet i dataindsamlingsperioden og som minimum havde været ansat på skolen siden begyndelsen af skoleåret.

Afgrænsningen af elevpopulationen og lærerpopulationen betyder at vi på baggrund af undersøgelsens resultater kan udtale os om kompetencer, holdninger og adfærd blandt danske 8.-klasseelever samt blandt lærere der underviser på 8. klassetrin. Det er altså vigtigt at understrege at undersøgelsens resultater ikke giver os et afsæt for at udtale os om elev- og lærergrupper på andre klassetrin i det danske skolesystem.

11.1.2 Stikprøvedesign

Når man ønsker et repræsentativt billede af en population – her de danske elevers computer- og informationskompetence og deres datalogiske tænkning – og samtidig skal kunne sammenligne resultaterne med resultater fra andre lande, skal man i alle landene følge de samme retningslinjer for hvordan man finder frem til de elever der skal testes. Udvælgelsen blev foretaget af IEA Hamburg. Skolerne blev udvalgt efter det der inden for fagterminologien kaldes en stratificeret klyngeudvælgelse hvor skoler der ligner hinanden på udvalgte karakteristika, samles i grupper, således at man sikrer en bred fordeling på tværs af typer. Stikprøvedesignet bestod af to faser.

I den første fase blev skolerne først sorteret i de valgte strata. I Danmark har vi adgang via Datavarehuset69 til karaktergennemsnit fra afgangsprøverne, og dette betragtes som en stærk indikator for resultat også i tests. Derfor valgte vi at dele skolerne op i fem grupper efter karaktergennemsnit (fire ligeligt fordelte grupper samt en gruppe af skoler for hvem gennemsnittet ikke kendes).70 Dernæst blev skolerne udtrukket til at deltage på baggrund af en PPS-procedure (probability proportional to size hvor størrelse måles som antal elever indskrevet på skolen). Derved blev det sikret at der var en spredt fordeling på tværs af skolestørrelser således at skoler med mange elever havde tilsvarende større sandsynlighed for at deltage end skoler med få elever.

Den nødvendige størrelse på den komplekse stikprøve af elever beregnes så den har samme præcision på henholdsvis gennemsnit og andele som hvis stikprøvedesignet blot bestod af en simpel tilfældig udtrækning af 400 elever fra elevpopulationen. I de fleste lande – og også i Danmark – resulterer det i en skolestikprøve på 150 skoler for at få tilpas præcise estimater. Landene kan dog ønske at få særlig viden om undergrupper, fx privatskoler eller skoler med mange elever med immigrantbaggrund, og i sådanne tilfælde vil de sample flere skoler (“oversample”) inden for dette område. Ud over de 150 skoler blev der for hver skole udtrukket to erstatningsskoler af samme type, så de kunne træde i stedet i tilfælde af at de udtrukne skoler ikke kunne deltage.

I anden fase af stikprøveudtrækket blev der inden for hver deltagende skole tilfældigt udtrukket i alt 20 elever til at deltage blandt de elever der var indskrevet på klassetrinnet. På skoler med færre end 20 elever blev alle elever på klassetrinnet inviteret til at deltage. Hvis skolen havde mere end 20 elever, men maksimalt 25 elever indskrevet i 8. klasse, blev alle elever inviteret til at deltage så de få ikke-deltagende elever ikke skulle føle sig ekskluderet.

Blandt lærerne blev anden fase i stikprøveudtrækket gennemført på følgende måde: Inden for hver deltagende skole blev 15 lærere tilfældigt udvalgt blandt alle lærere som underviste på målklassetrinnet. På skoler med færre end 20 lærere på klassetrinnet blev samtlige lærere inviteret til at deltage. Da der i undersøgelsen ikke lægges op til at forbinde viden fra lærerne med individuelle elever, blev lærerne altså udtrukket uafhængigt af om de underviste de udvalgte elever, eller hvilket fag de underviste i på klassetrinnet.

IEA-undersøgelserne stiller meget høje krav til deltagelsesgraden. I ICILS var dette krav på 85 procent af de udvalgte skoler og 85 procent af de udvalgte elever inden for de deltagende skoler – eller en vægtet samlet deltagelsesgrad på 75 procent. De samme kriterier gjaldt for lærerstikprøven, men dækningen blev vurderet uafhængigt af elevstikprøven. I Danmark lykkedes det at leve op til disse hårde deltagelseskrav for begge grupper, dog med det forbehold at der indgik skoler fra erstatningslisterne i stikprøven.

Nogle lande lykkedes ikke med at nå de meget stramme deltagelseskrav enten for elev- eller lærerpopulationen. Det drejer sig om USA for elevpopulationens vedkommende og om Frankrig, Luxemburg, Tyskland, Uruguay og USA for lærerpopulationens vedkommende. I den internationale rapport rapporteres disse landes resultater i en særlig afdeling af tabellerne. Vi har valgt af grafiske årsager at inkludere disse lande i samme afdeling som de øvrige lande i figurer og tabeller (så tabeller og figurer fremstår enkle og overskuelige). Det er vores vurdering at data har tilstrækkelig høj kvalitet til at dette valg er rimeligt.

11.2 Spørgeskemaer

For at kunne sige noget om konteksten for elevernes kompetencer indgik der i ICILS fem forskellige spørgeskemaer der blev besvaret henholdsvis af eleverne i forbindelse med testen og online af lærere, skoleledere, it-koordinatorer og den nationale forskningskoordinator. Spørgeskemaerne spiller en central rolle i ICILS-undersøgelsen ved at tilvejebringe information om forhold der relaterer sig til elevernes udvikling af computer- og informationskompetence samt datalogisk tænkning, herunder social baggrund og undervisningsmiljø.

Besvarelserne af spørgeskemaerne bidrager med viden om eksempelvis generelle tilgange og prioriteter i forhold til computer- og informationskompetence på et system- og skoleniveau, skolernes koordinering og samarbejde om brug af it i undervisningen, skole- og undervisningspraksis vedrørende brug af teknologier i forhold til elevers computer- og informationskompetence, læreres kompetencer og indstilling til samt erfaringer med at bruge computere, skolernes it-ressourcer samt om uddannelse og efteruddannelse af lærere.

I det følgende præsenteres de fem spørgeskemaer.71

11.2.1 Spørgeskemaet til eleverne

Eleverne besvarede spørgeskemaet i forbindelse med at de gennemførte ICILS-testen. Det indeholdt spørgsmål om elevens baggrund, erfaring med og anvendelse af computere og it til at løse forskellige opgaver i og uden for skolen samt deres holdning til brugen af computere og it. Elevspørgeskemaet spiller en central rolle i forhold til at kunne besvare ICILS-projektets forskningsspørgsmål om hvilke karakteristika i forhold til elevers adgang til, fortrolighed med og selvrapporterede kompetencer inden for anvendelsen af computere der relaterer sig til elevernes computer- og informationskompetence og kompetence i datalogiske tænkning, og om hvilke aspekter af elevernes personlige og sociale baggrunde (såsom køn, socioøkonomisk baggrund og sprogbaggrund) der relaterer sig til computer- og informationskompetence og kompetence i datalogiske tænkning.

11.2.2 Spørgeskemaet til lærerne

Lærerne blev spurgt til deres anvendelse af computere i skolen i forbindelse med planlægning, gennemførelse og evaluering af undervisningen, deres brug af computere uden for skolen samt deres kompetencer til at bruge computere.

Informationerne fra spørgeskemaerne giver som nævnt viden som bruges i den efterfølgende beskrivelse af den kontekst som computer- og informationskompetence og datalogisk tænkning udvikles inden for.

Da eleverne ikke undervises af lærerne i et specifikt fag knyttet til computer- og informationskompetence og datalogisk tænkning, kan deres it-relaterede kompetencer være påvirket af mange forskellige lærere. Derfor er det ikke muligt direkte at studere sammenhængen mellem lærerkarakteristika og elevernes præstationer. Data fra lærerspørgeskemaet kan til gengæld anvendes til at beskrive undervisningskonteksten, herunder lærernes brug af it, deres indstilling til it i undervisningen og egenopfattede færdigheder. Herudover kan lærerspørgeskemaerne anvendes til at se på sammenhænge mellem forskellige lærerkarakteristika – fx sammehænge mellem brug af it og indstilling til it.

11.2.3 Spørgeskemaet til skolelederne

Spørgeskemaet til skolelederne spurgte til skolens karakteristika (herunder eksempelvis skolens geografiske og demografiske kontekst), computerressourcer samt politik og praksis vedrørende anvendelse af informationsteknologier på skolen. Mere konkret indgik fx spørgsmål om skolens adgang til it og spørgsmål der belyser skolens tilgang til at arbejde med elevernes computer- og informationskompetence samt kompetencer i datalogisk tænkning.

11.2.4 Spørgeskemaet til it-koordinatorerne

Spørgeskemaet til it-koordinatorerne handler om skolens it-faciliteter, herunder de ressourcer og den støtte der eksisterer i forbindelse med at bruge it. Disse informationer er vigtige i beskrivelsen af for eksempel adgang til it og it-støtte til lærere. Spørgeskemaerne til it-koordinatorerne bidrager med perspektiver på den pædagogiske og didaktiske praksis der er for it på skolerne.

11.2.5 Spørgeskemaet til den nationale forskningskoordinator

Spørgeskemaet til den nationale forskningskoordinator giver viden om uddannelsessystemets struktur samt indsigt i hvordan computer- og informationskompetence og datalogisk tænkning er integreret i de nationale læseplaner.

Data fra dette spørgeskema kan bidrage til at skitsere den udvikling der har været inden for arbejdet med udvikling af elevernes computer- og informationskompetence og deres datalogiske tænkning. Derudover kan den bruges til at sammenligne hvordan der arbejdes med computer- og informationskompetence og datalogisk tænkning på tværs af lande og uddannelsessystemer samt give viden om kontekstuelle strukturer for uddannelse og uddannelsespolitik i de deltagende lande med mulighed for at lave analyser af forskellige tilgange til arbejde med it i de forskellige uddannelsessystemer.

Tilsammen bidrager de fem spørgeskemaer altså med vigtig viden i forhold til beskrivelse af den kontekst som computer- og informationskompetence og datalogisk tænkning udvikles inden for, og de giver mulighed for analyser af sammenhænge mellem elevernes besvarelser og de kontekster de indgår i. I det følgende præsenterer vi elevtestene med konkrete eksempler på opgaver.

11.3 Elevtest til måling af computer- og informationskompetence

Elevtesten til at måle elevernes computer- og informationskompetence blev udviklet over en periode på et år forud for gennemførelsen af den første ICILS-undersøgelse i 2013. Som led i forberedelserne til undersøgelsen i 2018 blev testen desuden udvidet med yderligere moduler. Den internationale forskningsledelse udviklede testen i samarbejde med nationale forskningskoordinatorer og eksperter på området. Testen bygger videre på eksisterende testmateriale der er udviklet til at måle digitale kompetencer (Binkley m.fl. 2012; Dede 2009) og computer- og informationskompetence (Australian Curriculum, Assessment and Reporting Authority 2012), og den er udarbejdet så den sikrer en ensartet testoplevelse på tværs af lande. ICILS var det første af alle IEA-studier der indsamlede data på computer og ikke på papir fra både spørgeskemaer og kompetencetest.

Testen er overordnet karakteriseret ved at:

- eleverne gennemfører testen individuelt på en computer.

- opgaverne er virkelighedsnære og integrerer fagligt indhold fra flere fag.

- opgaverne repræsenterer en kombination af elevernes receptive, tekniske og produktive kompetencer samt deres kompetencer til vurdering af sikker og etisk brug af computerbaseret information.

Til undersøgelsen i 2018 blev der anvendt i alt fem testmoduler. Der var mellem syv og tolv opgaver i testmodulerne, og de tog hver op til 30 minutter at gennemføre. Ud af de fem moduler blev eleverne præsenteret for to tilfældigt udvalgte moduler. Det betød at eleverne ikke nødvendigvis løste de samme opgaver som deres klassekammerater, men derimod arbejdede med forskellige typer af opgaver. Tre af modulerne var såkaldte trendmoduler. Trendmodulerne er kendetegnet ved at de også indgik da undersøgelsen blev gennemført i 2013, og de giver mulighed for at måle elevernes præstationer over tid. De to nye testmoduler fulgte de overordnede principper fra ICILS 2013. De blev udarbejdet så de komplementerede testen fra 2013 samtidig med at der blev udviklet nyt og mere tidssvarende indhold som afspejlede de forandringer der har været i elevernes anvendelse af computere siden 2013.

Et testmodul bestod af nogle mindre opgaver og spørgsmål indlejret i en autentisk narrativ ramme. De mindre opgaver tog typisk 1-2 minutter at løse og blev efterfulgt af en større opgave som tog 10-15 minutter at løse. Eleverne disponererede selv over tiden, men blev forud for testen gjort opmærksomme på at afsætte tid til at løse den store opgave.

Elevtestens brugerflade blev designet med henblik på at give eleverne en autentisk oplevelse af at arbejde med og løse forskellige opgaver på en computer. Testen blev afviklet offline, men simulerer de brugerflader eleverne almindeligvis arbejder med når de er på nettet eller anvender computer til eksempelvis præsentationer, tekstbehandling eller programmering. Eleverne præsenteres for nogle opgaver der varierer fra multiple choice-opgaver til opgaver hvor eleverne skal formulere korte tekstsvar og løse opgaver der måler tekniske færdigheder (fx deres evne til at redigere en tekst eller lave præsentationer) eller deres kommunikative færdigheder (fx deres evne til at søge information og kommunikere på nettet).

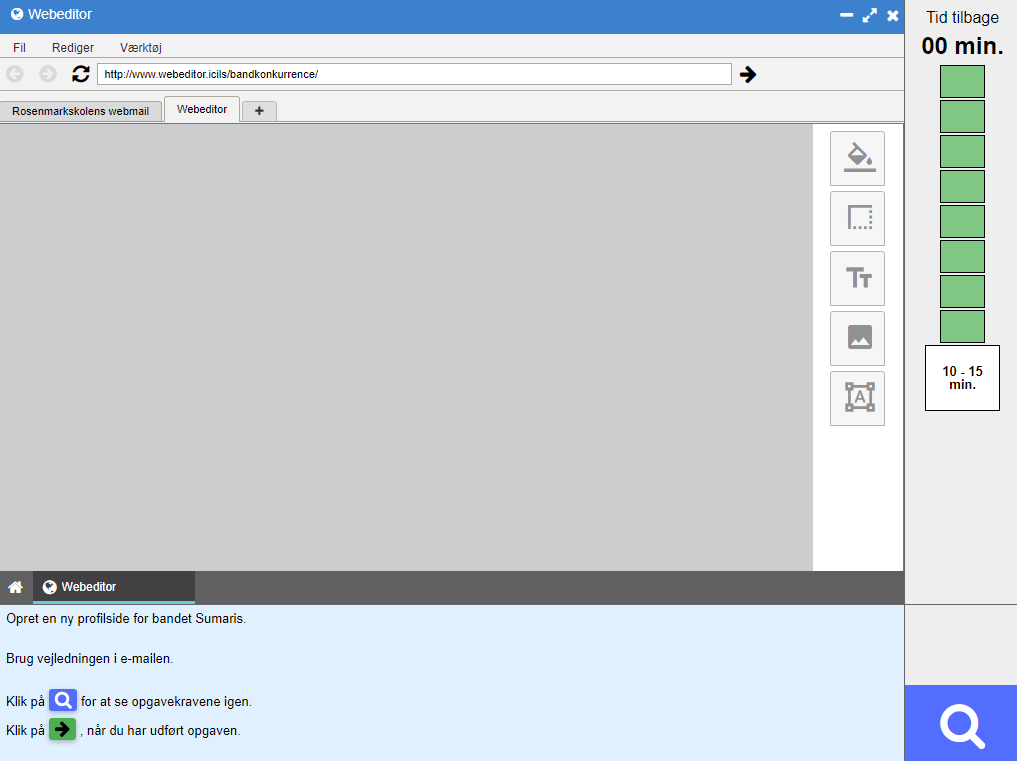

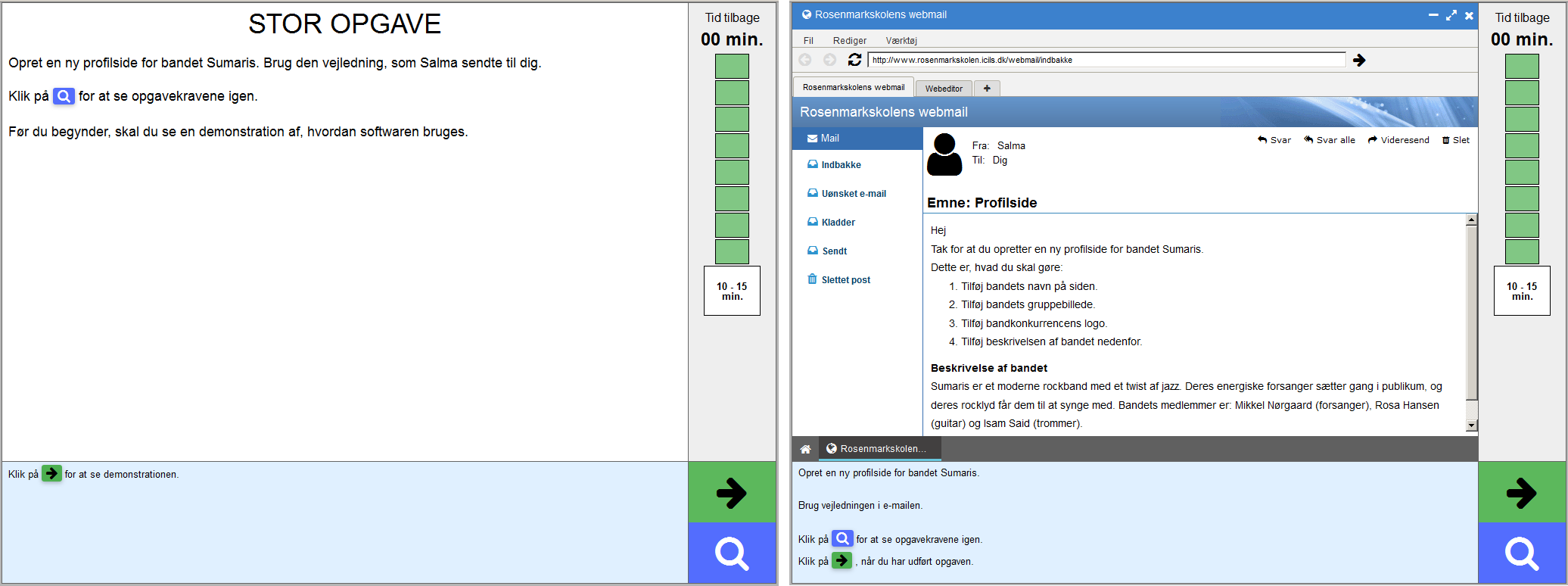

Figur 11.1 viser hvordan testens brugerflade så ud. Nederst til venstre kunne eleverne se instruktionerne til den opgave de skulle løse, og når de skulle skrive besvarelser på spørgsmål eller foretage valg, var det her det foregik. Til højre på skærmen kunne de se antallet af opgaver med “grønne klodser”, og her kunne de også følge med i hvor meget tid de havde tilbage til at løse opgaverne.

Figur 11.1: Testbrugerflade.

I øverste venstre del af skærmen kunne eleverne arbejde interaktivt og hente viden som de kunne bruge til at løse en given opgave. Det kunne for eksempel være at de skulle hente informationer på en hjemmeside som de skulle anvende i en præsentation.

Indledningsvis blev eleverne introduceret til hovedtemaet og formålet med opgaverne i testmodulet, og de fik en beskrivelse af hvori den store opgave bestod. Typisk bestod de mindre opgaver af færdighedsopgaver samt håndtering af information og fungerede som forberedelse til elevernes arbejde med den store opgave. I tabel 11.1 beskrives kort de fem testmoduler og de store opgaver.

11.3.1 Operationalisering af kompetenceområderne for computer- og informationskompetence

Tilsammen bidrager de fem testmoduler beskevet i tabel 11.1 til at måle, beskrive og analysere elevernes computer- og informationskompetence. I dette afsnit følger en detaljeret beskrivelse af hvordan kompetenceområderne blev operationaliset i udviklingen af testopgaverne og den vurdering af elevbesvarelserne der kunne fordele dem på en skala.

| Modul | Beskrivelse |

|---|---|

| Bandkonkurrence | Eleverne skal planlægge en konkurrence for skolebands. De skal anvende software til at opbygge en hjemmeside til udveksling af informationer i forbindelse med konkurrencen. |

| Åndedrættet | Eleverne skal udarbejde en præsentation der fortæller 8-9-årige om åndedrættet. De skal håndtere information, vurdere kilders troværdighed og målrette det produkt de laver. |

| Skolerejse | Eleverne skal hjælpe med at planlægge en skoleudflugt for deres klassekammerater. Ved hjælp af online databaseredskaber skal de udvikle et informationsark om turen og eksempelvis bruge et online ruteplanlægningsværktøj. |

| Brætspilklubben | Eleverne skal bruge et socialt skolenetværk til at lave opslag og beskeder der kan give elever lyst til at være med i skolens brætspilklub. |

| Genbrug | På en online videokanal til deling af videoer skal eleverne tilgå og forholde sig til videoer om genbrug. Formålet er at finde passende og troværdig information om emnet, tage noter på et computerbaseret noteværktøj samt designe et grafisk produkt som skaber opmærksomhed om genbrug og genanvendelse. |

Som beskrevet i kapitel 3 indeholder undersøgelsesrammen fire kompetenceområder som hver især indeholder forskellige aspekter. Undersøgelsesrammens struktur blev brugt som et organisatorisk værktøj til at sikre at alle dele af den mangefacetterede kompetence blev inkluderet i testredskabet. Til hvert aspekt er der udarbejdet opgaver som hver især giver point i forhold til det niveau besvarelsen er vurderet at være på. Nogle af de opgaver eleverne fik, kunne være rigtige eller forkerte og derved give 0 eller 1 point, mens andre kunne være delvist rigtige og derved kunne få 0, 1 eller 2 point. I alt var der 81 opgaver og spørgsmål som tilsammen indeholdt 102 point. Lidt over halvdelen af pointene blev givet i forbindelse med de fem store opgaver. Nedenfor angives hvor stor en procentandel af opgaverne der knytter sig til de fire kompetenceområder og de tilhørende otte aspekter.

11.3.1.1 Kompetenceområde 1: At forstå computerbrug, 14 procent

- Aspekt 1.1: Grundlæggende aspekter ved computerbrug, 2 procent

- Aspekt 1.2: Grundprincipper for computerbrug, 12 procent

11.3.1.2 Kompetenceområde 2: At indsamle information, 25 procent

- Aspekt 2.1: At tilgå og vurdere information, 15 procent

- Aspekt 2.2: At håndtere information, 10 procent

11.3.1.3 Kompetenceområde 3: At producere information, 50 procent

- Aspekt 3.1: At tilpasse information, 20 procent

- Aspekt 3.2: At skabe information, 30 procent

11.3.1.4 Kompetenceområde 4: Digital kommunikation, 11 procent

- Aspekt 4.1: At dele information, 8 procent

- Aspekt 4.2: At anvende information ansvarligt og sikkert, 3 procent

Som angivet i Fraillon, Ainley, Schulz, Duckworth, m.fl. (2019), blev testdesignet i ICILS ikke lagt an på at undersøge alle aspekter ved computer- og informationskompetencebegrebet i lige stort omfang. Formålet var at alle aspekter af autentiske, kontekstualiserede undersøgelsesaktiviteter blev dækket (Fraillon, Ainley, Schulz, Duckworth, m.fl. 2019, 54). Næsten tre gange så mange point relaterer sig til kompetenceområde 2 og 3 som til kompetenceområde 1 og 4. Fordelingen svarer til den forventede andel af tid som eleverne skulle bruge på opgaver knyttet til hvert kompetenceområde.

Forskerholdet bag ICILS anvendte Georg Raschs teori (Rasch 1960) til at skabe den kognitive skala fra de 81 opgaver som indgik i målingen af elevernes computer- og informationskompetence. I målingen af elevernes datalogiske tænkning, som vi præsenterer senere i dette kapitel, blev skalaen skabt på baggrund af 18 opgaver. Raschs model adskiller sig fra traditionelt testdesign hvor man blot tæller antal rigtige og sammenligner point på tværs af elever, ved at udregne en sværhedsgrad af hvert enkelt spørgsmål på baggrund af elevernes svar. Elevernes dygtighed kan derved komme på samme skala, og man kan fastsætte sandsynligheden for at en elev svarer rigtigt på en opgave med samme sværhedsgrad som elevens dygtighed til 50 procent. Jo dygtigere eleven er i forhold til opgavens sværhedsgrad, des større er sandsynligheden for at eleven kan svare rigtigt. Fordelen ved denne model er blandt andet at alle elever ikke behøver at få de samme opgaver så længe sværhedsgraden af opgaverne er udregnet på samme skala.

Derfor kunne hver elev nøjes med at besvare to af de fem moduler. Tildelingen blev organiseret så alle moduler kunne optræde sammen og alle komme først og alle sidst. Testdesignet gør det muligt at undersøge en større mængde indhold end det som ville kunne besvares af en enkelt elev på 60 minutter.

I internationale undersøgelser er der tradition for at elevernes dygtighed placeres på en skala med et gennemsnit på 500 og en standardafvigelse på 100. En standardafvigelse er det interval inden for hvilket 68 procent af elevernes resultater befinder sig. Det betyder at 68 procent af de deltagende elever i internationale undersøgelser med disse karakteristika vil ligge inden for et interval fra 400 til 600 point. I denne type undersøgelser fastlægger man ikke den enkelte elevs dygtighed, men giver nogle plausible bud på denne. Af statistiktekniske årsager (for at kunne udregne en mere præcis standardfejl) angiver man ikke blot et resultat for hver elev i databasen, men fem plausible værdier (von Davier, Gonzalez, og Mislevy 2009). Detaljer omkring skaleringsprocedurer for alle test-items vil fremgå af ICILS’ tekniske rapport (Fraillon m.fl. 2020).

11.3.2 Eksempler på testopgaver som måler elevernes computer- og informationskompetence

For at give en dybere forståelse af de fire kompetenceniveauer som er beskrevet i kapitel 3, præsenteres i det følgende eksempler på opgaver fra testmodulet Bandkonkurrence i forhold til disse kompetenceniveauer. Eksemplerne illustrerer karakteren og variationen i de opgaver eleverne arbejdede med da de gennemførte testen. Samtidigt viser de hvad testudviklerne vurderede at eleverne inden for de fire kompetenceniveauer kunne udføre af opgaver. Der beskrives fem eksempler på mindre opgaver fra testmodulet efterfulgt af en beskrivelse af den store opgave samt en beskrivelse af kriterierne for vurdering af opgaven. I testmodulet Bandkonkurrence skulle eleverne som nævnt udvikle en hjemmeside for et band der skulle deltage i en skolekonkurrence for bands.

11.3.2.1 Mindre testopgaver

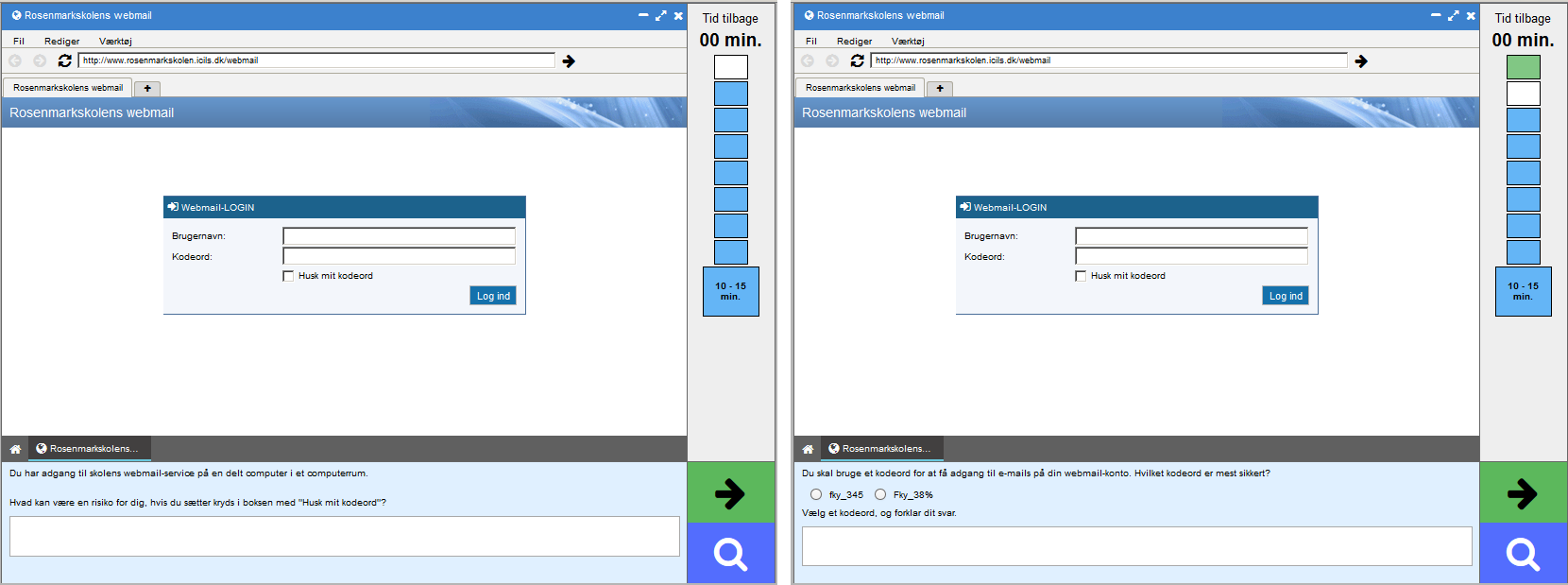

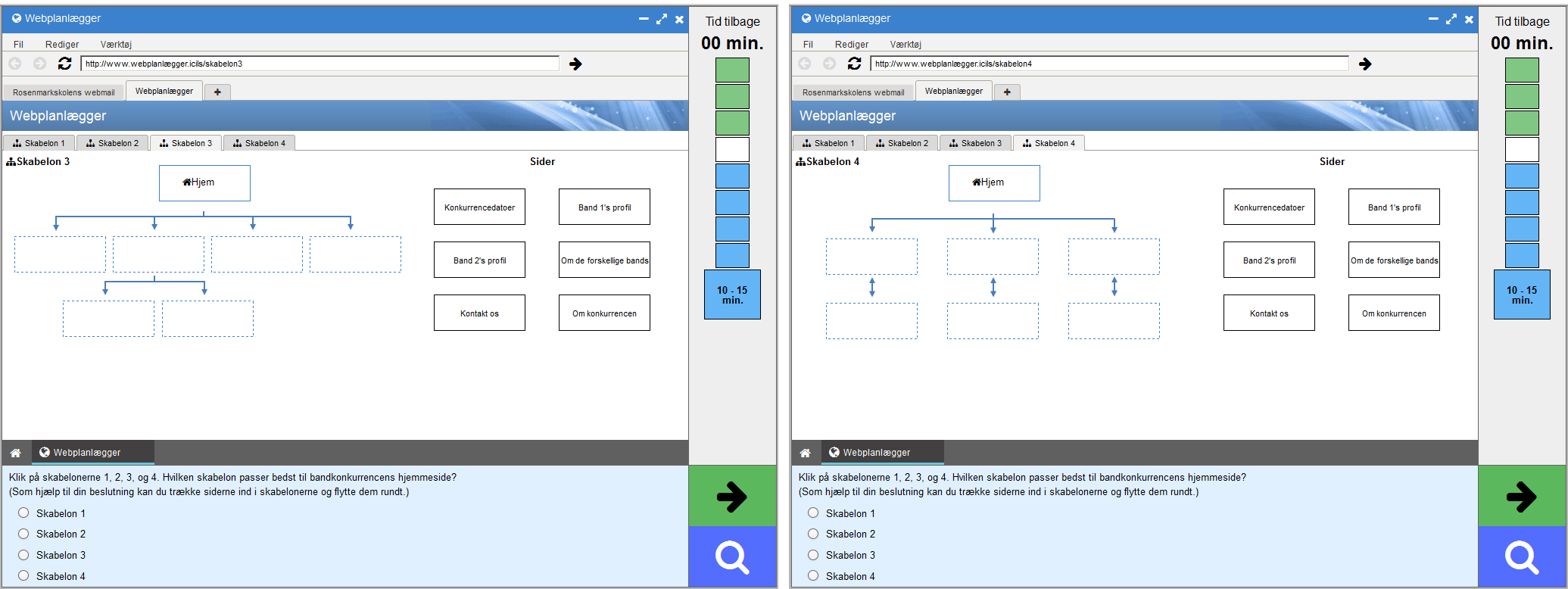

De to første eksempler (se figur 11.2) viser en fritekstopgave hvor eleverne selv skal formulere og skrive et svar i svarfeltet. I opgaven til venstre blev eleverne præsenteret for en loginside til en webbaseret e-mailkonto. I opgaven skulle eleverne svare på et spørgsmål som relaterede sig til sikkerhed i forbindelse med at logge ind på en offentligt tilgængelig computer. Dette eksempel illustrerer en opgave som elever på kompetenceniveau 1 kunne udføre. Opgaven måler elevernes forståelse for konsekvenserne af at lade en browser gemme et password på en computer der kan tilgås af andre. Elever der henviste til risikoen for at andre kunne få adgang til e-mailkontoen, eller nævnte at deres kodeord blev gemt på computeren, fik 1 point for besvarelsen. 72 procent af de danske elever kunne svare rigtigt på denne opgave, og procentandelen der svarede rigtigt, varierede mellem 50-84 procent i de deltagende lande.

Figur 11.2: To eksempler på små opgaver. Opgaven til venstre beder eleven forklare risikoen ved at markere ‘Husk mig’ på en delt computer. Opgaven til højre beder eleven vurdere det mest sikre kodeord og begrunde sit valg.

I eksemplet til højre i figur 11.2 skulle eleverne forklare hvordan et kodeord kan gøres mere sikkert. Eleverne blev præsenteret for to forskellige kodeord og skulle vælge det de vurderede var det mest sikre. Herefter skulle de i tekstboksen nederst på siden forklare deres valg. Elevernes besvarelse blev vurderet som rigtig hvis de valgte Fky_38% og refererede til at kompleksiteten i dette kodeord var større på grund af brug af forskellige tegn (tal, bogstaver, symboler). Dette eksempel illustrerer en opgave som elever på kompetenceniveau 2 på computer- og informationskompetenceskalaen kunne udføre. Blandt danske elever svarede 77 procent korrekt. Gennemsnittene på tværs af de deltagende lande varierede fra 27 til 80 procent.

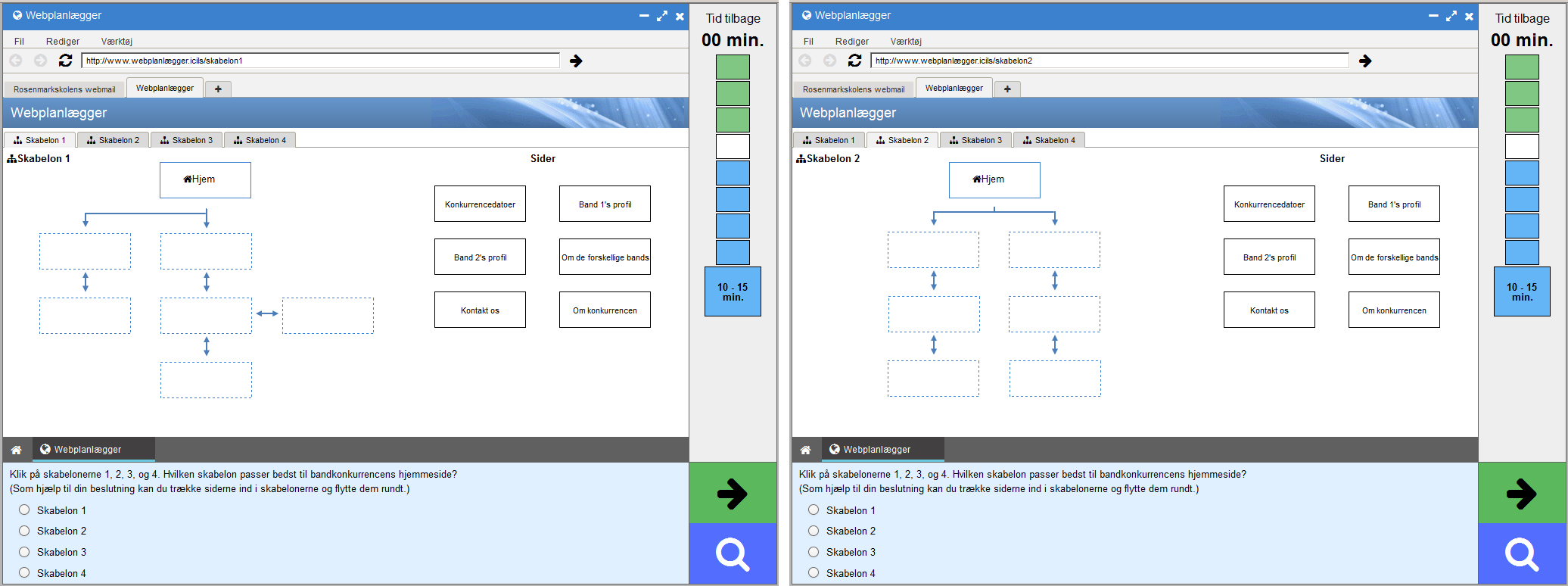

I det næste eksempel (se figur 11.3) blev eleverne præsenteret for fire skabeloner som repræsenterede fire mulige opsætninger af den hjemmeside som skulle præsentere bandet. Eleverne kunne se de forskellige skabeloner ved at klikke på fanebladene foroven. De kunne flytte og arrangere mærkaterne med indhold ved hjælp af en træk og slip-funktion. På den måde kunne de finde den skabelon de fandt mest passende til formidling af information om bandet. Elever der valgte skabelon nummer tre, fik point i opgaven.

Figur 11.3: Fire skabeloner til organisering af en hjemmeside. Opgaven beder eleven vælge den skabelon som hun vurderer bedst kan bruges til en hjemmeside der skal præsentere bandet.

Dette eksempel illustrerer en opgave på kompetenceniveau 3. Blandt danske elever svarede 34 procent korrekt, og på tværs af de deltagende lande varierede procentandelen der svarede korrekt, fra 23-40 procent.

I opgaven i figur 11.4 skulle eleverne kategorisere fem forskellige udsagn inden for tre kategorier: lovkrav, tekniske krav og sociale/personlige krav. Konkret skulle eleverne løse opgaven ved at trække udsagnene hen over skærmen og placere dem i de rigtige kategorier. Hvis eleverne kunne placere fire ud af fem udsagn korrekt, modtog de 1 point i denne opgave. En besvarelse på det niveau svarede til en dygtighed på kompetenceniveau 2 på skalaen for computer- og informationskompetence. Eleverne fik 2 point hvis de kategoriserede alle fem udsagn korrekt, og en besvarelse på det niveau svarede til grænsen mellem kompetenceniveau 3 og 4.

Blandt danske elever var det 80 procent der fik mindst 1 point, og på tværs af de deltagende lande varierede procentandelen der fik mindst 1 point, fra 37-83 procent. 27 procent af de danske elever fik 2 point, og her varierede procentandelen blandt de deltagende lande fra 10-35 procent.

Figur 11.4: Eksempel på en lille opgave. Eleverne skulle forholde sig til fem forskellige udsagn om at offentliggøre billeder på nettet.

11.3.2.2 En stor testopgave

I den store opgave i bandkonkurrencemodulet skulle eleverne designe en hjemmeside til et af de bands der skulle deltage i konkurrencen (se figur 11.5). Bandets hjemmeside var en underside på bandkonkurrencens hjemmeside. Indledningsvis fik eleverne en beskrivelse af den opgave de skulle løse. Derefter så de en kort præsentationsvideo om opgaven samt funktionerne i den software de skulle anvende til at løse den.

Figur 11.5: Eksempel på en stor opgave. Eleverne skal producere en hjemmeside til et band. Øverst til venstre: Introduktion til opgaven. Øverst til højre: En e-mail med instruktioner. Nederst til venstre: Websidedesigneren med et eksempel på en hjemmeside designet af en elev. Nederst til højre: Vurderingskritierierne som eleverne kunne få op ved at klikke på forstørrelsesglasset.

Som det fremgår af skærmbilledet nederst til venstre i figur 11.5, var der to faneblade på siden så eleverne kunne navigere mellem webeditoren (vist i figuren) og en e-mail fra en pige ved navn Salma. E-mailen er gengivet øverst til højre i figuren, og den indeholdt retningslinjerne for hvad hjemmesiden skulle indeholde. Eleverne skulle sikre sig at hjemmesiden indeholdt bandets navn, et foto af bandet, bandkonkurrencens logo og en beskrivelse af bandet. Beskrivelsen af bandet var inkluderet i slutningen af e-mailen og kunne kopieres og indsættes i en tekstboks. Klikkede eleverne på forstørrelsesglasset, fik de adgang til at se opgavekravene (se figuren nederst til højre).

Den store opgave bestod således fra start af en tom hjemmeside hvor eleverne skulle arbejde med layout ved hjælp softwarefunktioner. Softwarefunktioner og ikoner var designet så de fulgte almindelige konventioner for webbaserede redigeringsværkstøjer. Funktionerne blev anskueliggjort med ikoner som fremgår af skærmbilledet nederst til venstre i figur 11.5.

Redigeringssoftwaren gav eleverne de grundfunktioner der kendes fra typiske billed- og tekstredigeringsværktøjer. De kunne således tilpasse baggrundsfarve eller sætte et billede ind som baggrund. De kunne tilføje tekst og formatere den i størrelse, skrifttype med mere. De kunnne indsætte billeder fra et billedgalleri, og de kunne indsætte figurer og ikoner. De kunne tilføje kanter til billederne og tilpasse deres farve og form. Billederne kunne flyttes rundt, og størrelsen på dem kunne ændres.

Testsystemet gemte automatisk versioner løbende som en backup når eleverne løste opgaverne, så de kunne vende tilbage til samme sted i opgaven hvis de oplevede tekniske problemer. Når eleverne havde færdiggjort hjemmesiden, skulle de klikke på den grønne pil nederst på siden. Når eleverne forlod modulet, blev den endelige version af hjemmesiden gemt så den kunne blive vurderet efter de givne kriterier. I det følgende beskrives disse kriterier nærmere.

11.3.3 Vurderingskriterier i forhold til kompetenceniveauer for computer- og informationskompetence

I en stor opgave var der typisk 7-10 forskellige kriterier der skulle vurderes. I eksemplet fra testmodulet Bandkonkurrence præsenteret ovenfor hvor eleverne skulle designe en appellerende hjemmeside til et band, blev elevernes præstationer vurderet ud fra de følgende syv kriterier:

- Brug af logo

- Brug af bandets navn

- Brug af tekst i forhold til læsevenlighed, formatering og layout

- Tekstkontrast

- Bandbeskrivelse

- Brug af bandbeskrivelse og bandfoto

- Hjemmeside – layout og balance på siden.

Overordnet var kriterierne inddelt i to kategorier: tekniske færdigheder og informationshåndtering. Kriterier der knytter sig til de tekniske færdigheder, relaterede sig typisk til elementer som tekst- og billedformatering samt brug af farver i opgaverne. De tekniske færdigheder blev differentieret ud fra en vurdering der gik fra lidt eller ingen kontrol i den lavere ende til færdigheder der styrkede det kommunikative udtryk i den højere ende. Kriterierne knyttede sig altså ikke alene til elevernes evne til at kunne anvende tekniske færdigheder, men også deres evne til at anvende færdighederne med et kommunikationsformål for øje.

De kriterier der knyttede sig til informationshåndtering, handlede om hvorvidt eleverne målrettede deres information for eksempel ved at vælge relevant og fravælge irrelevant materiale i deres produkt. Nogle kriterier blev vurderet dikotomt ved at elevernes besvarelser kun kunne gives 0 eller 1 point, mens elevernes besvarelser på andre opgaver kunne gives 0, 1 eller 2 point. En mere detaljeret beskrivelse af hvordan den kvalitative vurdering af opgaverne blev varetaget, følger i afsnit 11.3.4. Kriterierne for vurderingen af opgaven afhang af opgavens udformning. Nogle opgaver indeholdt præsentationer med flere slides, og i den type opgaver afspejlede kriterierne elevernes evne til at kunne anvende formatering samt præsentere indhold konsistent både på enkelte slides og på tværs af hele præsentationen.

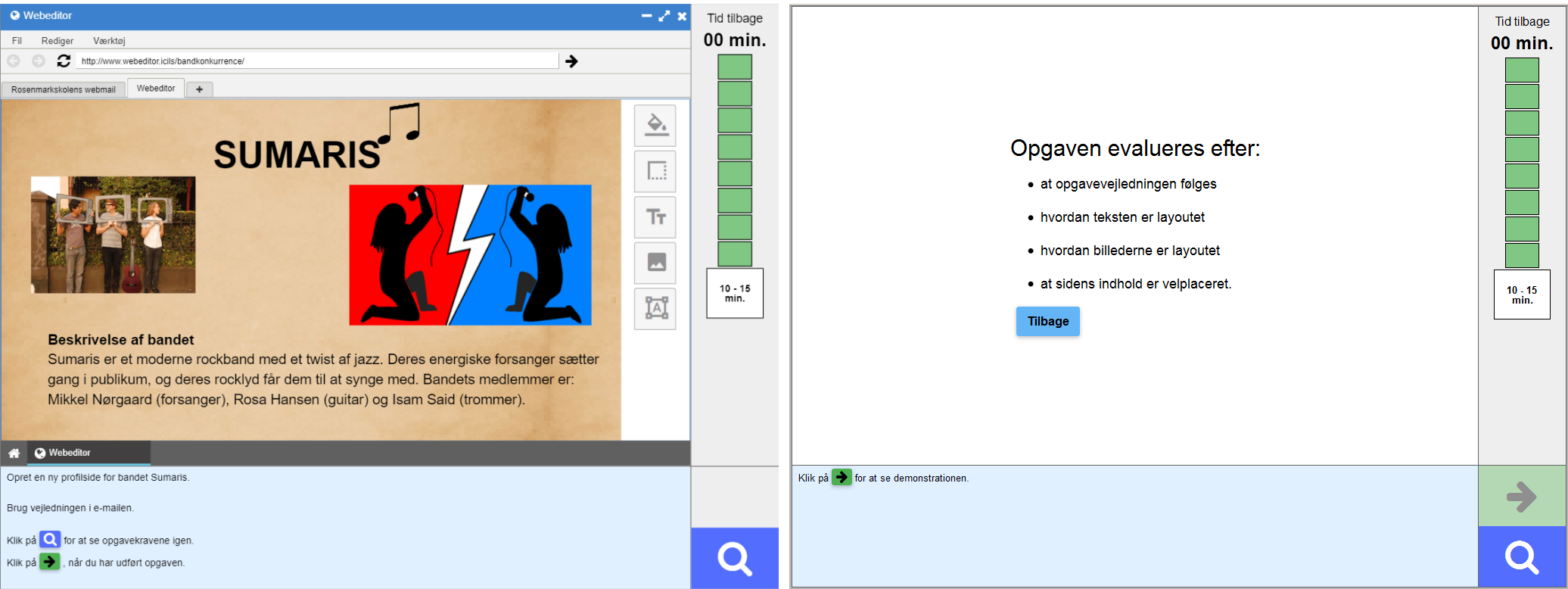

I Bandkonkurrencens store opgave skulle eleverne designe en hjemmeside, og derfor knyttede vurderingskriterierne sig til de elementer og det indhold der almindeligvis er på en hjemmeside. I tabel 11.6 præsenteres vurderingskriterierne for opgaven kort og relateres til kompetenceområder og aspekter. Kompetenceniveauerne er angivet fra 1 til 4, og kriterierne er sorteret efter sværhedsgraden på skalaen for computer- og informationskompetence fra den sværeste til den letteste. Andelen af de deltagende elever der svarede korrekt, er angivet med procent.

Figur 11.6: Kompetenceniveauer og vurderingskriterier for den store opgave i modulet Bandkonkurrencen.

Tabellen viser altså hvordan kriterierne relaterer sig til forskellige kompetenceniveauer. En elev på kompetenceniveau 2 eller derover vil have mindst 50 procents sandsynlighed for at få 1 point på kriterie 4 (tekst: kontrast). Ved nogle kriterier (fx brug af logo) kunne elevernes besvarelser gives 0, 1 eller 2 point. Som tabellen viser, hænger koden på dette kriterie sammen med vidt forskellige kompetenceniveauer. Elever på niveau 1 og derover vil have mindst 50 procents sandsynlighed for at få ét pont, mens kun elever på det øverste kompetenceniveau vil have mere end 50 procents sandsynlighed for at få 2 point på dette kriterium.

11.3.4 Kvalitativ vurdering af opgavebesvarelserne for computer- og informationskompetence

En del af elevernes svar blev vurderet automatisk. Imidlertid indeholdt testen også fritekstopgaver samt store opgaver hvor eleverne eksempelvis havde til opgave at udarbejdede et produkt.

Det har stor betydning for undersøgelsen at vurderingerne er konsistente – derfor blev elevbesvarelserne vurderet på baggrund af kodningsvejledninger der blev udviklet til de enkelte testmoduler. Vejledningerne beskrev detaljeret kriterierne for hvordan besvarelserne kunne gives point for de forskellige opgaver, og der blev givet eksempler på konkrete elevbesvarelser der illustrerede kriterierne. Vejledningerne blev udarbejdet af forskningsledelsen på baggrund af indhentede erfaringer fra to forundersøgelser (i 2012 og 2017) og fra hovedundersøgelsen ICILS 2013. Vejledningerne blev afprøvet og diskuteret på et ugelangt møde med deltagelse af de nationale forskningskoordinatorer og lederne for vurdering af elevbesvarelserne med henblik på at sikre at de opstillede kriterier var tilstrækkelige til at koderne klart kunne skelne mellem de forskellige niveauer for elevernes præstationer.

Efter afviklingen af undersøgelsen blev der ansat 10 universitetsstuderende til at kode elevbesvarelserne fra Danmark. Disse “kodere” gennemgik et oplæringsforløb hvor kodevejledningerne blev gennemgået i detaljer, afprøvet og diskuteret indtil der ikke var tvivlsspørgsmål. Koderne gennemførte træningskodningsmoduler der indeholdt 15-30 eksempler på elevbesvarelser for hver opgave, inden de påbegyndte den egentlige vurdering. Træningsmodulerne gjorde det muligt at se om der var afvigelser som gav anledning til ekstra træning eller tilpasning i forhold til vurderingen af en given opgave. Når der var opnået en tilstrækkelig overensstemmelse i forståelsen af vurderingen af de enkelte opgaver, blev adgangen til elevbesvarelserne åbnet.

Koderne blev instrueret i at godtage korte svar så længe eleven gennem sin besvarelse viste forståelse for den stillede opgave. Tilsvarende måtte elevernes stavning, tegnsætning og anvendelse af grammatik ikke tages i betragtning og påvirke vurderingen af besvarelserne.

Der blev anvendt et program som fordelte elevbesvarelserne tilfældigt mellem koderne, og som registrerede deres kodning af de enkelte opgaver. 15 procent af opgaverne blev tilfældigt udtrukket og vurderet af to tilfældigt udvalgte kodere med henblik på at måle inter-koder-reliabiliteten, det vil sige graden af overensstemmelse mellem forskellige koderes vurdering af den samme opgave. Den nationale leder for vurderingen af elevbesvarelserne fulgte løbende med i processen og identificerede opgaver med relativ lav reliabilitet med henblik på enten at genkode alle opgaver eller tilbyde mere træning for at forbedre kvaliteten af kodningen. Opgaver med for lav realibilitet (under 70 procent) blev ikke medtaget i estimeringen af elevernes samlede resultat. Yderligere information om kvalitetssikringen af data kan læses i ICILS’ tekniske rapport (Fraillon m.fl. 2020).

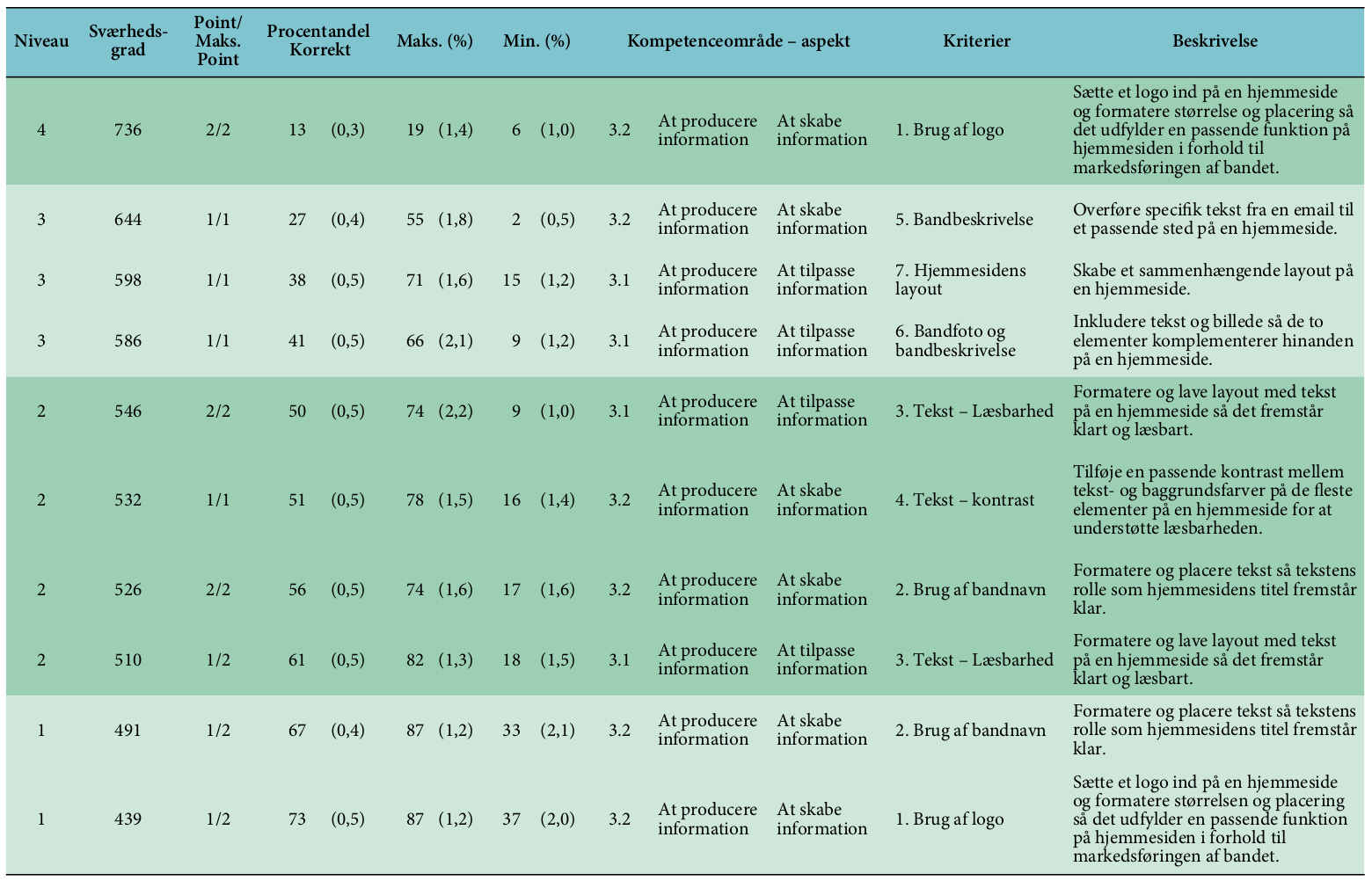

I programmet til vurdering af elevbesvarelserne kunne koderne se selve opgaven og elevens besvarelse af den. I højre side af skærmen var der mulighed for at angive de point som koderen vurderede at opgaven skulle tildeles.

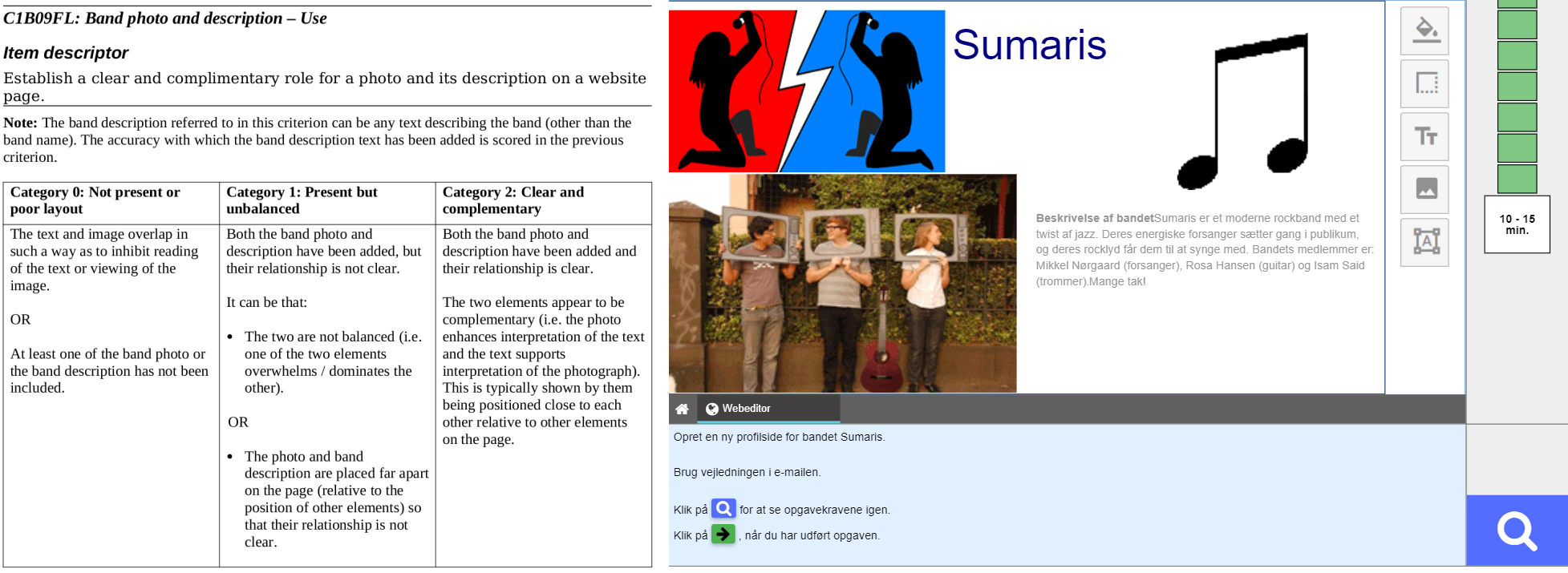

Figur 11.7: Kodning af elevbesvarelser. Til venstre: kriterier for kodning af elevernes succes med at indsætte en beskrivelse af bandet fra testmodulet Bandkonkurrence. Manualen var den originale på engelsk. De danske kodere beherskede engelsk tilstrækkeligt godt til at vi ikke fandt det nødvendigt at oversætte manualen. Til højre: Eksempel på en vurdering af en elevbesvarelse.

Vurderingen af elevbesvarelserne foregik som tidligere nævnt på baggrund af kodningsmanualer med detaljerede beskrivelser af kriterierne for hvordan besvarelserne kunne gives point i de forskellige opgaver. I dettte afsnit bliver det med udgangspunkt i en elevbesvarelse fra testmodulet Bandkonkurrence forklaret hvordan vurderingskriterierne blev omformet til de koder der fastsatte niveauet for en elevbesvarelse. Figur 11.7 viser uddrag af kodningsmanualen og en elevbesvarelse der skulle vurderes af koderne. Koderen skulle vurdere syv kriterier i denne opgave.

11.3.4.1 1. Brug af logo

Dette vurderingskriterie kunne vurderes med pointene 0, 1 eller 2. Elevernes besvarelser blev vurderet i forhold til om logoet var sat ind på siden, havde en passende størrelse og var placeret hensigtsmæssigt i forhold til andre elementer på siden. Elevbesvarelsen blev kodet 0 hvis logoet ikke var på siden. Der blev kodet 1 hvis logoet var sat ind på siden, men tog større fokus end bandfotoet eller teksten – hvis det eksempelvis blev anvendt som baggrund. Og der blev kodet 2, hvis logoet udfyldte en passende position og funktion på hjemmesiden i forhold til markedsføringen af bandet. Eleverne måtte gerne anvende logoet flere gange på siden. I det viste eksempel på en elevbesvarelse fik besvarelsen koden 2 for dette vurderingskriterie fordi logoet var mindre end fotoet og havde en passende position på siden.

11.3.4.3 3. Brug af tekst i forhold til læsevenlighed, formatering og layout

Dette vurderingskriterie undersøgte om eleverne havde anvendt tekststørrelse, layout (herunder linielængde og overlap) til at øge læsebarheden. For at kunne gives 1 eller 2 point skulle der være tekst på siden, og al tekst, på nær bandets navn, indgik i vurderingen. Bandnavnet indgik ikke i vurderingen fordi det blev vurderet under kriteriet Brug af bandets navn. Elevbesvarelser hvor der ikke indgik tekst, hvor tekststørrelsen enten var for stor eller for lille, linielængden var for smal eller tekstboksene overlappede, blev vurderet med koden 0. Besvarelser hvor der både indgik elementer der opfyldte ovenstående krav og elementer der ikke gjorde, blev kodet med 1. Besvarelser hvor ingen elementer på siden var for store eller for små eller overlappede hinanden blev kodet med 2. I det viste eksempel fik besvarelsen koden 2. Den anvendte tekst på siden er let at læse, den er hverken for stor eller for lille, linielængden er tilpas, og der ikke overlap mellem tekstbokse og billeder.

11.3.4.4 4. Tekstkontrast

Dette kriterie målte den indflydelse kontrast mellem baggrund og tekst har på om teksten fremstår letlæselig. For at kunne gives 1 eller 2 point skulle der indgå tekst i besvarelsen, og al tekst på siden skulle indgå i vurderingen. Elevbesvarelser hvor der var svag eller ingen kontrast mellem tekst og baggrund, samt besvarelser hvor der slet ikke indgik tekst på siden, blev kodet med 0. Besvarelser hvor nogle tekstelementer fremstod med kontrast og andre ikke gjorde, fik koden 1. Elevernes besvarelser fik koden 2 når der var en passende kontrast mellem baggrundens farve og tekstelementerne på siden således at teksten fremstod let at læse. I det viste eksempel fik besvarelsen koden 1. Denne del af vurderingen blev foretaget af en algoritme. Koderen kunne revidere koden hvis hun vurderede at algoritmen ikke havde givet den rette kode. I denne opgave blev revurderingen ligeledes kodet med 1 fordi noget tekst på siden fremstod med kontrast til baggrunden (titlen), mens andet tekst fremstod med for lidt kontrast til baggrunden.

11.3.4.5 5. Bandbeskrivelse

I dette vurderingskriterie blev det vurderet hvorvidt eleverne havde fulgt en instruktion og inddraget de elementer de blev bedt om på hjemmesiden. Her kunne besvarelserne enten få 0 eller 1 point. Besvarelserne fik koden 0 hvis de ikke havde bandbeskrivelse med, eller hvis de kun havde dele af bandbeskrivelsen med. Besvarelserne fik ikke point hvis de indsatte den komplette bandbeskrivelse inklusive den afsluttende hilsen fra e-mailen: ‘Mange tak!’. For at besvarelsen kunne få kode 1 skulle eleverne kopiere og indsætte den komplette bandbeskrivelse fra e-mailen. I det viste eksempel fik besvarelsen koden 0 fordi eleven havde kopieret al tekst ind på hjemmesiden inklusive “Mange tak!”.

11.3.4.6 6. Brug af bandbeskrivelse og bandfoto

Vurderingskriterie 6 angik om bandfotoet og bandbeskrivelsen komplementerede hinanden på siden. Under dette kriterie blev indholdet af bandbeskrivelsen ikke vurderet da denne del allerede var vurderet i vurderingskriteriet ‘bandbeskrivelse’. Hvis tekst og billede overlappede hinanden, eller hvis enten foto eller beskrivelse var udeladt, blev besvarelsen kodet med 0. Hvis både beskrivelsen og fotoet indgik, men ikke komplementerede hinanden, blev besvarelsen kodet med 1. Der blev givet kode 2 hvis de to elementer fremstod i en klar relation til hinanden på siden. Typisk hvis de stod tæt på hinanden i forhold til de andre elementer på siden. Besvarelsen fik i eksemplet koden 2 fordi bandbeskrivelsen og bandfotoet komplementerede hinanden på siden. Eksempelvis stod de to elementer tæt på hinanden i relation til de andre elementer på siden.

11.3.4.7 7. Hjemmeside – layout og balance på siden

Dette kriterie målte om eleverne havde arbejdet med layout og udformet et velafbalanceret udtryk på hjemmesiden. Det var en vurdering af hvorvidt de tre elementer: billede, bandbeskrivelse og bandfoto fremstod velafbalanceret på siden. Hvis eleverne havde udeladt to eller flere elementer, blev besvarelsen kodet med 0. Tilsvarende blev der kodet 0 hvis elementer fremstod for store eller for små i relation til hinanden, hvis pladsen på siden ikke var udnyttet hensigtsmæssigt, eller hvis der blev gjort overdreven brug af effekter eller redigering på siden. Besvarelsen fik koden 1 hvis deres design indeholdt mindst to af de tre elementer, og hvis de fremstod i et velafbalanceret forhold til hinanden og havde en passende størrelse i forhold til andre elementer på siden. I eksemplet her fik besvarelsen koden 0 fordi foto og logo var placeret i den ene side og gav et uafbalanceret udtryk.

11.4 Elevtest til måling af datalogisk tænkning

Testen til måling af elevernes datalogiske tænkning blev udviklet i forbindelse med ICILS 2018. Dette afsnit beskriver i detaljer hvordan elevernes datalogiske tænkning blev målt, herunder beskrives testmodulerne, operationalisering af kompetenceområderne, eksempler på testopgaver, vurderingskriterier samt kvalitativ vurdering af opgavebesvarelserne.

Elevtestens brugerflade blev designet med henblik på at give eleverne en autentisk oplevelse af at arbejde med de brugerflader eleverne almindeligvis arbejder med hvis de udvikler programmeringsløsninger. Testen blev afviklet offline på en computer.

Testinstrumentet bestod af to testmoduler: Selvkørende bus og Landbrugsdronen. Hvert modul tog maksimalt 25 minutter at gennemføre. Alle elever gennemførte begge moduler, men i tilfældig rækkefølge. Eleverne fik testen umiddelbart efter at de først havde gennemført testen i computer- og informationskompetence samt udfyldt et spørgeskema og holdt en af de indlagte pauser.

| Modul | Beskrivelse |

|---|---|

| Selvkørende bus | Eleverne skal indstille et navigations- og bremsesystem i en selvkørende bus. For eksempel skal de bruge en simulation til at teste bremselængden for en selvkørende bus. |

| Landbrugsdronen | Eleverne skal programmere en landbrugsdrone. De arbejder på en simpel programmeringsflade med udvikling, test, fejlretning og vurdering af algoritmer. |

11.4.1 Operationalisering af kompetenceområderne for datalogisk tænkning

Modulet Selvkørende bus fokuserede på Kompetenceområde 1: At identificere problemer, mens modulet Landbrugsdronen fokuserede på Kompetenceområde 2: At udvikle løsninger. I testmodulet Selvkørende bus blev eleverne præsenteret for nogle opgaver der relaterede sig til konfiguration af et navigations- og bremsesystem i en selvkørende bus. I modulet Landbrugsdronen arbejdede eleverne med kodebokse på et arbejdsområde hvor de kunne udvikle og forbedre algoritmer ved at trække og slippe kodeboksene. Alt i alt indeholdt testen 39 point fra 18 opgaver. De fleste af elevernes besvarelser blev vurderet automatisk af en computer. Enkelte mere åbne opgaver hvor eleverne fik mulighed for at svare med fritekst, blev ligesom det var tilfældet med computer- og informationskompetencetesten vurderet af kodere der var uddannet til at varetage opgaven.

I nedenstående liste ses fordelingen af opgaver på kompetenceomåder og aspekter (Fraillon, Ainley, Schulz, Duckworth, m.fl. 2019, 29).

11.4.1.1 Kompetenceområde 1: At identificere problemer, 41 procent

- Aspekt 1.1: At have indsigt i og forstå digitale systemer, 18 procent

- Aspekt 1.2: At formulere og analysere problemer, 10 procent

- Aspekt 1.3: At indsamle og repræsentere relevant data, 13 procent

11.4.1.2 Kompetenceområde 2: At udvikle løsninger, 59 procent

- Aspekt 2.1: At planlægge og vurdere løsninger, 33 procent

- Aspekt 2.2: At udvikle algoritmer, programmer og brugerflader, 26 procent.

11.4.2 Eksempler på testopgaver som måler elevernes datalogiske tænkning

I dette afsnit præsenteres en række eksempler fra testmodulet Landbrugsdronen der illustrerer karakteren af de opgaver som indgik i testen. Eksemplerne anskueliggør samtidig variationen i de opgaver eleverne arbejdede med, da de gennemførte testen.

11.4.2.1 Landbrugsdronen

I testmodulet Landbrugsdronen arbejdede eleverne med en drone der skulle bruges i forbindelse med drift af et landbrug. Eleverne arbejdede med kodning på en simpel programmeringsflade udviklet til formålet. Eleverne anvendte kodeblokke med forskellige funktioner til at udvikle, teste eller finde fejl i en algoritme. Opgaven til venstre i figur 11.8 viser første opgave i testmodulet og illustrerer samtidig brugerfladen. Brugerfladen var inddelt i to funktionsområder, en testbrugerflade og et programmeringsområde. Inddelingen svarede til den der blev anvendt i målingen af elevernes computer- og informationskompetence: Den nederste del og den højre side af skærmen indeholdt selve testbrugerfladen og blev brugt til at give eleverne de instruktioner der knyttede sig til opgaven. I højre side af skærmen kunne eleverne se hvor meget tid der var tilbage af testsessionen. I Landbrugsdronen var det, i modsætning til de andre testmoduler, muligt for eleverne at navigere frem og tilbage mellem opgaverne ved at klikke på de grønne klodser. Eleverne kunne også markere en opgave med et flag så de, hvis de havde tid tilovers, let kunne vende tilbage til de markerede opgaver og eventuelt forbedre deres besvarelse. Programmeringsområdet betod af tre adskilte områder: et område hvor kodeblokkene var placeret (nederst til venstre), et \(9\times9\)-gitter hvori dronen kunne udføre de handlinger som den blev kodet til at udføre (øverst i venstre hjørne), og et centralt placeret arbejdsområde hvor eleverne kunne indsætte kodeblokke ved at trække og slippe dem.

I alle opgaverne i testmodulet blev eleverne præsenteret for den samme brugerflade, men med forskelle i den visuelle udformning af landbruget, fx afhængig af hvilke afgrøder der var visualiseret (små eller store afgrøder). Der var også forskel på hvilke og hvor mange kodeblokke eleverne fik stillet til rådighed til at løse opgaverne. I opgaver hvor eleverne selv skulle udarbejde algoritmer, var den eneste kodeblok der var placeret på arbejdsområdet, kodeblokken ved kørsel. Når eleverne eksempelvis trak funktions-kodeblokken gå frem ind i arbejdsområdet og satte den sammen med ved kørsel-blokken og trykkede på den grønne afspilningsknap, gik dronen et skridt frem. Eleverne havde mulighed for at trykke på den blå reset-knap, og på den måde kunne de komme tilbage til det oprindelige udgangspunkt for dronen. De kunne også trykke på den orange reset-knap i arbejdsområdet hvis de ønskede at komme tilbage til det oprindelige udgangspunkt på arbejdsområdet.

De første to eksempler illustrerer opgaver der repræsenterer kompetenceområdet At udvikle løsninger. I opgaven til venstre i figur 11.8 bliver eleverne bedt om at anvende gentagelses-blokken til at sprøjte vand på fire jordfelter uden at ramme nogen græsfelter.

Figur 11.8: To opgaver fra testmodulet Landbrugsdronen. I opgaven til venstre skal eleven sprøjte vand på fire jordfelter. I opgaven til højre skal eleven finde fejl i en eksisterende algoritme.

92 procent af de danske elever kunne løse opgaven, men en del af disse elever brugte signifikant flere kodeblokke end det mindste antal af kodeblokke man kunne bruge for at løse opgaven korrekt. Disse elevbesvarelser fik 1 point og placerede sig i den lavere ende af det nederste kompetenceinterval.72 Procentandelen af besvarelser der fik mindst 1 point, lå mellem 83 og 92 procent i deltagerlandene.

Elever som løste opgaven ved brug af gentagelses-blokken, og som samtidig anvendte lidt flere kodeblokke i deres algoritme end det mindst nødvendige for at svare helt korrekt, fik 2 point for deres besvarelse og placerede sig i det nederste kompetenceinterval. 83 procent af de danske elever løste opgaven som beskrevet og deres besvarelse fik mindst 2 point. Procentandelen der fik 2 point, varierede mellem 73-86 procent i deltagerlandene.

Elever der løste opgaven ved at gøre brug af gentagelses-blokken, og som gjorde det effektivt ved at bruge det mindst nødvendige antal kodeblokke, fik 3 point for deres besvarelse. 26 procent af de danske elever formåede at løse opgaven på dette niveau. Procentandelen der fik 3 point, varierede i deltagende lande fra 16-40 procent. De besvarelser placerede sig i det øverste kompetenceinterval.

I højre side af figur 11.8 ses en opgave hvor eleverne skulle finde fejl i en algoritme som allerede var udviklet i arbejdsområdet. Opgaven har en høj sværhedsgrad. Algoritmen bestod af fem kodeblokke, og eleverne skulle rette op på en fejl for at få dronen til at løse en opgave.

I opgaven skulle eleverne få dronen til at sprøjte vand på de små og de store afgrøder. Dertil skulle dronen også sprøjte gødning på de små afgrøder. I algoritmen var en hvis-blok i en gentagelses-blok så der var tale om både ikke-lineær (gentagelse) og betinget (hvis) logik.

Algoritmen var kodet til at sprøjte med gødning og vand afhængig af afgrødens størrelse. I de mest simple løsninger af opgaven kunne eleverne placere anvend vand-blokken før hvis-blokken og efter ryk frem-blokken samt rekonfigurere kommandoen i hvis-blokken til små afgrøder.

I gennemsnit kunne 70 procent af de danske elever løse opgaven, men en stor gruppe af dem anvendte mange flere kodeblokke end det mindste antal kodeblokke de kunne bruge. Typisk flyttede eleverne gentagelses- og hvis-blokken væk fra arbejdsområdet og gjorde i stedet brug af lineær logik ved at anvende ryk frem-blokken og anvend vand-blokken. Disse elevbesvarelser fik 1 point og indikerede præstationer der placerede sig i det nederste kompetenceinterval på skalaen for datalogisk tænkning. Variationen mellem landene var 48-74 procent.

Elever der kunne løse opgaven ved at anvende gentagelses-blokken og hvis-blokken sammen, og som kun anvendte et lille antal kodeblokke ud over mindsteantallet af kodeblokke, fik 2 point for deres besvarelse. Disse besvarelser placerede sig på det miderste kompetenceinterval på skalaen for datalogisk tænkning. Variationen mellem landene var 25-48 procent, og i Danmark fik 39 procent af eleverne mindst 2 point for deres besvarelse.

I gennemsnit kunne 8 procent af alle elever fra de deltagende lande rette algoritmen ved at anvende det mindste antal af kodeblokke der skulle til for at løse opgaven, og gennemsnittet varierede fra 3-12 procent på tværs af de deltagende lande. Disse besvarelser fik 3 point, og eleverne hvis besvarelse fik 3 point, havde typisk en kompetence i det øverste kompetenceinterval. Disse elever udviste generelt klar kontrol i brugen af ikke-lineær logik (fx med gentagelsesblokke) i deres arbejde med algoritmer. I Danmark var 8 procent af eleverne i stand til at løse opgaven på dette niveau.

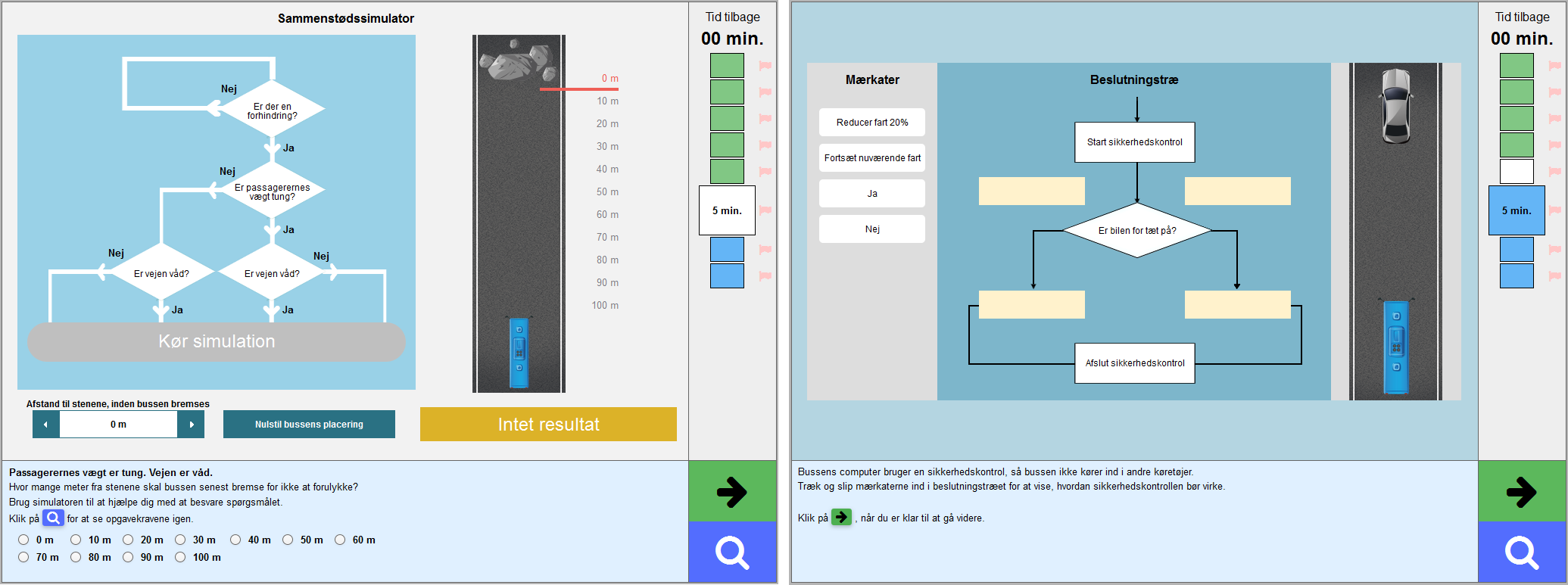

11.4.2.2 Selvkørende bus

I figur 11.9 ses en opgave fra modulet Selvkørende bus. Opgaven falder inden for kompetenceområdet At identificere problemer. I opgaven skulle eleverne anvende en bremsesimulator for en selvkørende bus og konfigurere den for at finde den mindste distance bussen skulle bruge på at bremse under givne omstændigheder. Først skulle eleverne indstille rutediagrammet i forhold til to forudsætninger der var gældende: at vejen er våd og at passagernes vægt er tung. Efterfølgende kunne eleverne indstille bremsedistancen og køre simulationen for at afprøve om bussen stoppede efter hensigten eller ramte klipperne.

Figur 11.9: To opgaver i modulet Selvkørende bus. I opgaven til venstre skulle eleverne indstille beslutningstræet og derefter tjekke hvilken afstand bussen skulle have til klipperne for at den kunne nå at stoppe før den ramte dem. I opgaven til højre skulle eleverne udarbejde et beslutningstræ for at vise hvordan en sikkerhedskontrol bør virke.

Besvarelserne kunne få 0, 1 eller 2 point i denne opgave. Besvarelser hvor eleverne konfigurerede rutediagrammet forkert, men angav en bremsedistance der var konsistent med den indstilling de havde lavet, fik 1 point. Besvarelser hvor eleverne konfigurerede rutediagrammet korrekt og angav en bremsedistance der var konsistent med indstillingen, fik 2 point. Besvarelser der fik både 1 og 2 point, lå typisk i det miderste kompetenceinterval, men i henholdsvis den lavere og højere ende af intervallet.

I Danmark fik 64 procent af eleverne mindst 1 point for deres besvarelse, og 40 procent fik 2 point. Procentandelen af eleverne der fik mindst 1 point for deres besvarelse af opgaven, lå mellem 50-72 procent i deltagerlandene, mens procentandelen som fik 2 point, lå mellem 28-58 procent.

Opgaven til højre i figur 11.9 fungerede som en forberedende opgave forud for opgaven hvor eleverne skulle konfigurere bremsesimulatoren. I opgaven blev eleverne bedt om at færdiggøre et beslutningstræ ved at trække og slippe mærkater (fra venste side af skærmen) ind på de rigtige pladser. Eleverne skulle sikre konsistens mellem placeringen af mærkaterne og den logik der fremstod i beslutningstræet.

De elever der kunne trække ja og nej over i beslutningstræet og placerede dem i de øverste felter, men samtidigt placerede Reducer fart 20 % og Fortsæt nuværende fart under den forkerte beslutning, fik 1 point for deres besvarelse. Ligeledes fik elever der trak ja og nej til de nederste felter i beslutningstræet, men samtidigt placerede Reducer fart 20 % og Fortsæt nuværende fart under den rigtige beslutning, også 1 point for deres besvarelse. Disse besvarelser svarede til at eleverne havde en kompetence i det miderste interval på kompetenceintervalskalaen.

Elever der kunne fuldende beslutningstræet ved at gøre brug af både den rigtige logik og den rigtige placering af mærkaterne, fik 2 point for deres besvarelse af opgaven. Disse elever havde typisk en dygtighed i det øverste kompetenceinterval på skalaen.

I Danmark fik 55 procent af eleverne mindst 1 point for deres besvarelse, og 29 procent fik 2 point. Procentandelen af eleverne der fik mindst 1 point for deres besvarelse, lå mellem 50-56 procent i deltagerlandene, mens procentandelen som fik 2 point, lå mellem 20-37 procent.

11.4.3 Vurderingskriterier i forhold til kompetenceintervaller for datalogisk tænkning

Opgaverne blev sværere og sværere i takt med at eleverne arbejdede sig igennem testmodulet. Sværhedsgraden for opgaverne afhang af følgende karakteristika:

- Variationen i anvendelsen af forskellige kodefunktioner (bevægelse, handling, gentagelse eller betingelse).

- Antallet af mål (et mål er det felt hvorpå der eksempelvis skal udføres en handling såsom sprøjt gødning på små afgrøder).

- Antallet af forskellige typer mål (eksemplevis jordlodder eller små og store afgrøder).

- Hvorvidt der skal foretages mere end én handling over et givent mål.

- Antallet af forskellige materialer der skal tilføres målet (frø, vand eller gødning).

Opgavernes sværhedsgrad knyttede sig altså til funktionen af de kodeblokke der var til rådighed, samt til antallet af kodeblokke som eleverne anvendte for at få landbrugsdronen til at løse de opgaver som blev stillet. Eleverne fik opgaver hvor de skulle anvende kodeblokkene til at udarbejde algoritmer, og de fik opgaver hvor de skulle finde fejl i allerede eksisterende algoritmer.

I testmodulet Landbrugsdronen blev alle opgaverne vurderet automatisk af en computer og kategoriseret på baggrund af to karakteristika. For det første handlede det om korrekthed, altså hvor korrekt dronen udførte de handlinger som var specificeret i opgavebeskrivelsen. Dette inkluderede både i hvilken grad dronen udførte de opgaver den skulle, og om der var unødvendige handlinger. Og for det andet effektivitet. Effektiviteten blev målt ved at optælle antallet af anvendte kodeblokke og sammenligne det med det mindste antal af kodeblokke der kunne bruges til at løse opgaven korrekt. Til opgaverne knyttede der sig en instruktion om at eleverne skulle anvende så få kodeblokke som muligt.

Hver opgave fik en samlet kode som blev beregnet ved at kombinere koderne fra henholdsvis korrekthed og effektivitet. For de fleste opgavers vedkommende blev den kode der blev givet i effektivitet, brugt til at moderere den samlede kodning for et fuldstændigt korrekt svar (korrekthed). Flere detaljer om vurderingen af opgaverne i testmodulet Landbrugsdronen, vil fremgå af ICILS’ tekniske rapport (Fraillon m.fl. 2020).

11.4.4 Kvalitativ vurdering af opgavebesvarelserne for datalogisk tænkning

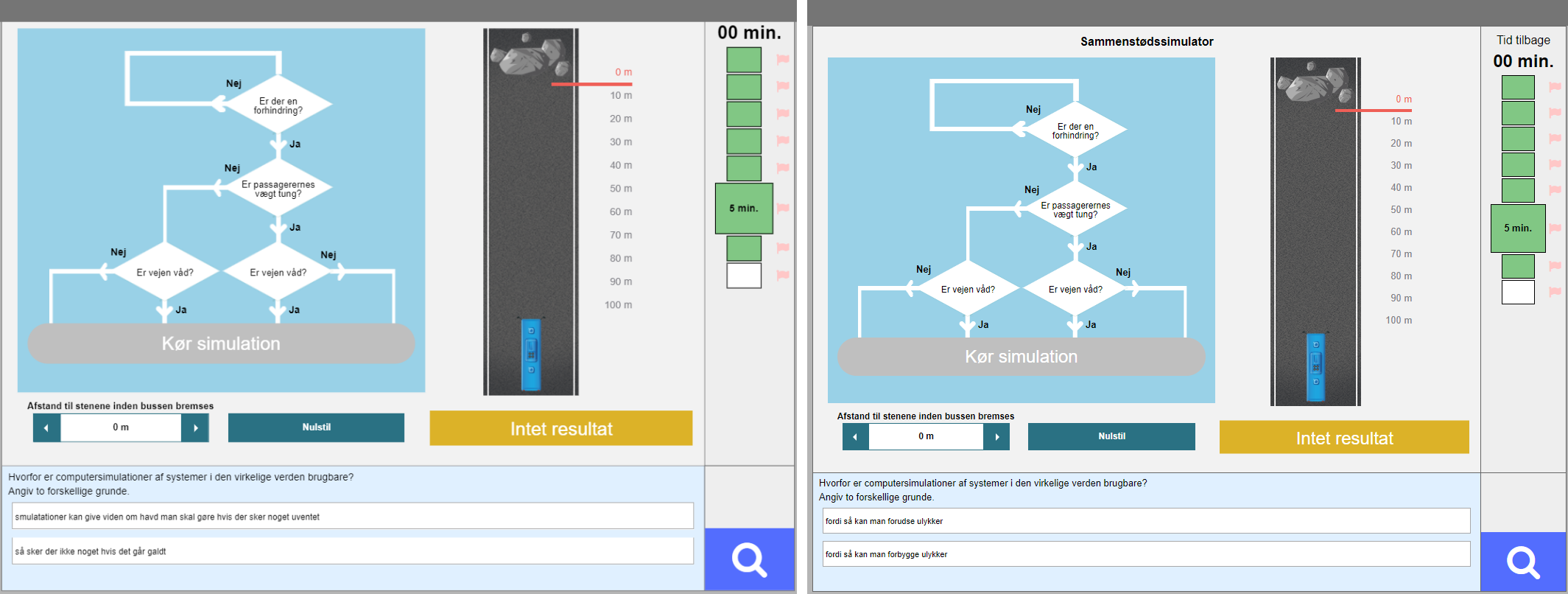

Afsnit 11.3.4 beskriver hvordan vurderingerne af opgavebesvarelserne for både computer- og informationskompetence samt datalogisk tænkning overordnet set blev foretaget. I det følgende retter vi specifikt fokus på den kvalitative vurdering af opgavebesvarelserne for datalogisk tænkning med et eksempel på hvordan en opgave fra testmodulet Selvkørende bus blev vurderet (alle opgaver i Landbrugsdronen blev kodet automatisk). Det var kun opgaver med korte skriftlige svar fra eleverne der skulle kodes af mennesker.

I opgaven som eksemplerne stammer fra, blev eleverne bedt om at give to forskellige grunde til hvorfor simulationer kan være brugbare i forhold til at løse virkelige problemer. Besvarelserne kunne kodes til 0, 1 eller 2 point. Der var fem mulige begrundelser som kunne give point:

- Det kan være farligt at afprøve systemer i virkeligheden.

- Virkelige systemer kan ikke laves eller kan være vanskelige at lave.

- Simulationer gør det lettere at kontrollere forskellige forhold.

- Simulationer muliggør at store mængder data let kan blive indsamlet.

- Simulationer er billigere end virkelige systemer.

Besvarelserne fik koden 2 hvis svaret relaterede til mindst to af disse begrundelser, og 1 point hvis det inddrog en af begrundelserne. Figur 11.10 viser to besvarelser. Til venstre ses et eksempel på en besvarelse der fik koden 2. Eleven svarede her:

- Simulationer kan give viden om hvad man skal gøre hvis der sker noget uventet

- Så sker der ikke noget hvis det går galt.

Første del af besvarelsen får point fordi besvarelsen knytter sig til at simulationer kan give en viden man ellers ikke ville have fået fordi man ikke har mulighed for at afprøve det samme med virkelige systemer. Anden del af besvarelsen får point fordi eleven refererer til begrundelse et som peger på faren ved at afprøve noget i virkeligheden. Der gives altså 2 point for denne besvarelse.

Figur 11.10: To eksempler på elevbesvarelser fra testmodulet Selvkørende bus. Besvarelsen til venstre gives 2 point. Besvarelsen til højre gives 1 point.

Besvarelsen til højre i figur 11.10 blev givet koden 1. Her svarede eleven:

- Fordi så kan man forudse ulykker

- Fordi så kan man forebygge ulykker.

Begge dele af besvarelsen giver en begrundelse inden for den første type, altså om faren ved at afprøve noget i virkeligheden. Når en elev besvarede opgaven med to svar som blev vurderet til at indgå under samme kategori, blev besvarelsen kodet med 1. En tredje elev svarede:

- Det bruges til næsten alt, apps, hjemmesider og meget mere

- Det kan bruges til det tekniske og det it-relaterede på en computer.

Ingen dele af elevens to svar kunne knyttes til de oplistede begrundelser. En sådan besvarelse blev vurderet som irrelevant i forhold til den stillede opgave og fik således koden 0.

B Referencer

Binkley, Marilyn, Ola Erstad, Joan Herman, Senta Raizen, Martin Ripley, May Miller-Ricci, og Mike Rumble. 2012. “Defining Twenty-First Century Skills”. I Assessment and Teaching of 21st Century Skills, redigeret af Patrick Griffin, Barry McGaw, og Esther Care. Dordrecht: Springer Netherlands. http://www.springerlink.com/index/10.1007/978-94-007-2324-5.

Davier, Matthias von, Eugenio Gonzalez, og Robert J. Mislevy. 2009. “What Are Plausible Values and Why Are They Useful?” I IERI Monograph Series Volume 2, 9–36.

Dede, Chris. 2009. “Comparing Frameworks for 21st Century Skills”. Harvard Graduate School of Education.

Fraillon, Julian, John Ainley, Wolfram Schulz, Daniel Duckworth, og Tim Friedman. 2019. IEA International Computer and Information Literacy Study 2018 Assessment Framework. Cham: Springer International Publishing. https://doi.org/10.1007/978-3-030-19389-8.

Fraillon, Julian, Wolfram Schulz, Tim Friedman, John Ainley, Eveline Gebhardt, John Ainley, Ralph Carstens, m.fl. 2020. ICILS 2018: technical report.

Rasch, G. 1960. Probabilistic Models for Some Intelligence and Attainment Tests. Studies Im Mathematical Psychology, Vol. 1. Copenhagen: Danmarks pædagogiske Institut.

I Danmark regnes børnehaveklassen ikke med som første års skolegang, hvorfor det for Danmarks vedkommende var 8. klasse der deltog.↩

Statificeringen er implicit for Danmark, så data om stratificeringen indgår ikke i databasen.↩

Spørgeskemaerne kan ses og hentes i deres fulde længde på edu.au.dk/icils↩

Beskrivelse af kompetenceintervallerne findes i kapitel 4, tabel 4.2.↩